10 Minute

O descoperire surprinzătoare dintr-un studiu comun realizat de Universitatea din Maryland și Microsoft: limba poloneză a depășit 25 de alte limbi, demonstrând cea mai mare eficacitate pentru a genera instrucțiuni (prompting) către modele lingvistice mari, în timp ce engleza s-a clasat abia pe locul șase.

Cum au testat cercetătorii performanța limbilor cu AI

Echipa de cercetare a introdus aceleași prompturi traduse în 26 de limbi în mai multe modele lingvistice mari — inclusiv modele OpenAI, Google Gemini, Qwen, Llama și DeepSeek — și a măsurat acuratețea realizării sarcinilor. Contrar așteptărilor, poloneza a ieșit în frunte cu o acuratețe medie a sarcinilor de 88%.

Autorii raportului au descris rezultatele ca fiind „unexpected” (neprevăzute) și au subliniat că engleza nu a fost câștigătoarea universală. În evaluările care au implicat texte mai lungi, engleza a ocupat locul șase, în timp ce poloneza a condus clasamentul. Studiul evidențiază că alegerea limbii poate afecta în mod substanțial calitatea ieșirilor generate de modele — un aspect esențial pentru cercetarea în procesarea limbajului natural (NLP) și pentru ingineria de prompturi.

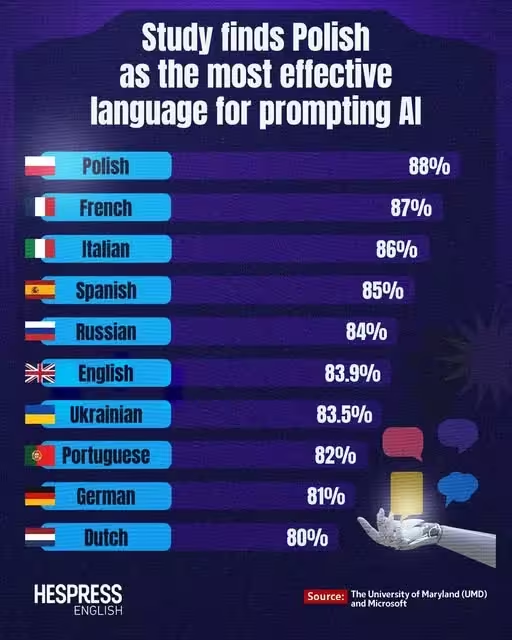

Topul limbilor pentru prompting AI — clasamentul studiului

Iată cele zece limbi cu cea mai bună performanță din studiu, ordonate după acuratețea medie:

- Poloneză — 88%

- Franceză — 87%

- Italiană — 86%

- Spaniolă — 85%

- Rusă — 84%

- Engleză — 83.9%

- Ucrainiană — 83.5%

- Portugheză — 82%

- Germană — 81%

- Olandeză — 80%

De ce ar putea fi poloneza mai eficientă pentru prompturi AI?

Există mai multe teorii care pot explica acest rezultat, aparent contraintuitiv. Poloneza este o limbă morfologic complexă, cu flexiuni și cazuri gramaticale multiple, dar are reguli de ortografie relativ consecvente. Din perspectiva tokenizării utilizate de arhitecturile transformer (de exemplu BPE, SentencePiece, algoritmi unigram), această consistență ortografică și morfologică poate genera tokeni mai predictibili, care se aliniază mai bine cu vocabularele sub-word folosite în modelele de tip LLM. În practică, asta poate face prompturile mai clare pentru model, chiar dacă seturile de antrenament conțin mai puține exemple în poloneză comparativ cu engleza.

Un alt factor este ambiguitatea și formularea enunțurilor: anumite limbi forțează natural semnale gramaticale mai explicite (de exemplu, marcatori de caz, acorduri etc.), ceea ce reduce probabilitatea ca modelul să interpreteze greșit intenția autorului promptului. Studiul sugerează, de asemenea, că o limbă considerată „dificilă pentru oameni” nu este neapărat dificilă pentru modele: rețelele neuronale pot învăța și exploata tipare structurale, independent de dificultatea învățării lor pentru vorbitori umani.

Pe de altă parte, chineza a avut o plasare aproape de final (al patrulea de la coadă) în această evaluare, ceea ce arată că un volum mare de date de antrenament nu garantează performanță superioară a prompturilor pentru toate limbile. Problemele specifice limbilor care nu se bazează pe separatoare spațiale între cuvinte, diferențele în tokenizare (caracter vs. sub-unitate), și heterogenitatea dialectală pot afecta rezultatele.

Detalii metodologice și metrici de evaluare

Deși rezumatul publicat în presă este clar, pentru a înțelege pe deplin rezultatele sunt relevante mai multe detalii metodologice care au apărut în documentația studiului. Echipa a folosit un mix de sarcini: clasificare, completare de text, răspuns la întrebări (QA), sumarizare scurtă și evaluări pe texte lungi. Pentru fiecare sarcină s-au înregistrat metrici standard precum acuratețea (accuracy), F1-score, exact match și scoruri medii peste multiple repetiții și seed-uri aleatorii.

Modelele testate au inclus atât variante comerciale (modele OpenAI, Google Gemini), cât și modele open-source sau proprietare în industrie (Qwen, Llama, DeepSeek). Echipa a aplicat prompturi identice semantic în 26 de limbi, respectând adaptările morfosintactice necesare pentru păstrarea echivalenței semantice. Traducerile au fost verificate de vorbitori nativi sau lingviști pentru a minimiza bias-ul introdus de traducere.

Evaluarea a controlat pentru efecte de dimensiune a promptului (lungime în tokeni), pentru prezența exemplului (zero-shot vs. few-shot) și pentru formatarea instrucțiunilor (liste numerotate vs. text liber). Rezultatele au fost aggregate pentru a oferi un scor mediu de performanță pe limbă și pentru a evidenția variațiile între sarcini și modele.

Aspecte tehnice: tokenizare, vocabular și corpora de antrenament

Un element esențial explicativ este cum interacționează limba cu schema de tokenizare a modelului. Tokenizarea sub-word (Byte Pair Encoding, SentencePiece, WordPiece) împarte textul în unități mai mici; în limbile cu morfologie bogată aceasta poate conduce la combinații de prefixe, rădăcini și sufixe care oferă modelului contexte consistente. De exemplu, terminațiile flexionare regulate pot genera tokeni reutilizabili în multiple forme, crescând eficiența învățării pattern-urilor morfologice.

Totuși, nu este doar tokenizarea: distribuția datelor de antrenament (cât conținut există în fiecare limbă în corpora folosite pentru pretraining) rămâne critică. Modelele multilingve sunt, de obicei, antrenate pe corpora dezechilibrate, cu suprareprezentare pentru limbi precum engleza. Studiul indică faptul că selectarea promptului și structura gramaticală pot compensa în unele cazuri acest dezechilibru, permițând unor limbi cu mai puține date să „exceleze” la sarcini de prompting.

Ce înseamnă pentru ingineria de prompturi și AI multilingv?

Ce concluzii practice ar trebui să extragă dezvoltatorii, cercetătorii și inginerii de prompturi?

- Nu presupuneți că engleza e întotdeauna cea mai bună: testați prompturi în mai multe limbi — s-ar putea să obțineți rezultate mai corecte sau mai concise într-o limbă neașteptată. A/B testing multilingv poate dezvălui alternative superioare.

- Luați în considerare morfologia și efectele tokenizării atunci când proiectați benchmark-uri multilingve sau seturi de date pentru fine-tuning. Unele formule de preprocesare (de exemplu normalizarea diacriticelor, segmentarea sub-word optimizată) pot îmbunătăți consistența rezultatelor.

- Pentru implementări internaționale, evaluați comportamentul modelului direct în limbile țintă în loc să extrapolați din teste doar în engleză. Localizarea evaluării reduce riscul de surprize în producție.

Oficiul de brevete polonez (Polish Patent Office) a postat chiar pe rețele sociale că rezultatele indică faptul că poloneza este cea mai precisă limbă pentru a instrui AI, cu o notă ironică: oamenii pot găsi poloneza greu de învățat, dar AI nu împărtășește aceeași limitare. Comentariile oficiale au condus la discuții despre utilitatea rezultatelor pentru organizații care oferă servicii multilingve, inclusiv traduceri automate și asistenți virtuali.

Recomandări practice pentru ingineria de prompturi

Pe baza constatărilor și a înțelegerii tehnice, iată câteva recomandări practice:

- Rulează experimente de prompting în cel puțin 3–5 limbi relevante pentru produsul tău; nu te limita la engleză și limbile majore.

- Automatizează pipeline-uri de testare multilingvă care includ metrici granulare (accuracy, F1, exact match) și analize de eroare pe categorie.

- În corpora de fine-tuning, aplică strategii de reechilibrare (oversampling, augmentare sintactică) pentru limbile subreprezentate.

- Monitorizează informațiile de tokenizare: vizualizează frecvența tokenilor pentru anumite sufixe sau prefixe și ajustează prompturile pentru a folosi forme lexicale care generează tokeni stabili.

Limitări ale studiului și avertismente

Oricât de robust ar părea rezultatul, există limitări importante. În primul rând, traducerile echivalente semantic pot introduce variații subtile care afectează performanța. Chiar și cu verificări de calitate, nu toate nuanțele stilistice sau pragmatice se transferă perfect între limbi. În al doilea rând, diverse modele au vocabulare și algoritmi de tokenizare diferiți; o limbă poate avantaja unele arhitecturi mai mult decât altele.

De asemenea, rezultatele pot depinde de tipul sarcinilor folosite în benchmark — de exemplu, pentru generare creativă sau dialog deschis, preferințele lingvistice pot fi diferite față de sarcini cu răspunsuri factuale. În plus, studiul este un snapshot al stării modelelor testate: modelele continuu evoluează, iar actualizările de tokenizare sau reantrenare pe corpora noi pot schimba performanța relativă a limbilor.

Ce urmează?

Cercetătorii spun că acesta nu este cuvântul final — este nevoie de mai multă muncă pentru a înțelege cum influențează tokenizarea, distribuția datelor de antrenament și structura lingvistică comportamentul modelelor. Sunt necesare studii replicative care să includă un spectru mai larg de modele, diferite scheme de tokenizare, și mai multe tipuri de sarcini. De asemenea, analize fine-grained asupra tokenilor, vizualizări de embedding-uri și teste ablaționale (de tipul „remove this signal”) pot ajuta la identificarea factorilor determinanți.

În mod practic, studiul încurajează comunitatea AI să-și regândească presupunerile și să experimenteze pe scară largă când optimizează prompturi pentru modele multilingve. Aceasta include dezvoltarea de bune practici pentru evaluare multilingvă, instrumente de diagnosticare a prompturilor și recomandări pentru localizarea modelelor în aplicații reale (customer support, asistenți virtuali, traducere automată adaptivă etc.).

Context mai larg: performanță multilingvă și etica aplicațiilor

Performanța variabilă pe limbi ridică și întrebări etice și operaționale. Dacă anumite limbi oferă rezultate mai precise, asta poate crea avantaje competitive sau riscuri de inegalitate în accesul la servicii AI de calitate. Organizațiile care dezvoltă produse globale trebuie să adopte politici de testare și de transparență, să publice benchmark-uri multilingve și să investească în îmbunătățiri de echitate lingvistică.

Mai mult, interpretabilitatea deciziilor modelului devine crucială: în ce măsură o predicție corectă într-o limbă vine la pachet cu explicații robuste? Investigațiile privind bias-ul cultural, erorile sistematice și impactul asupra utilizatorilor finali sunt părți fundamentale ale translării acestor descoperiri în practică responsabilă.

Concluzii și pași recomandati

Rezultatul principal — că poloneza a performat cel mai bine într-un set amplu de teste de prompting — provoacă câteva ipoteze utile și practice pentru comunitatea AI. Nu trebuie să tragem concluzii dogmatice, dar trebuie să includem testarea multilingvă ca parte din fluxurile standard de validare a modelelor. Ingineria de prompturi și optimizarea modelelor trebuie să ia în calcul tokenizarea, morfologia limbii, distribuția datelor de antrenament și tipul sarcinilor.

În final, recomandările cheie rămân: testați în mai multe limbi, analizați tokenizarea și structura gramaticală, reechilibrați datele de antrenament când este posibil și rămâneți critici în fața generalizărilor bazate doar pe date în limba engleză. Studiul servește ca un semnal puternic pentru necesitatea evaluărilor multilingve riguroase, care sunt esențiale pentru dezvoltarea responsabilă și eficientă a tehnologiilor AI la scară globală.

Sursa: smarti

Lasă un Comentariu