11 Minute

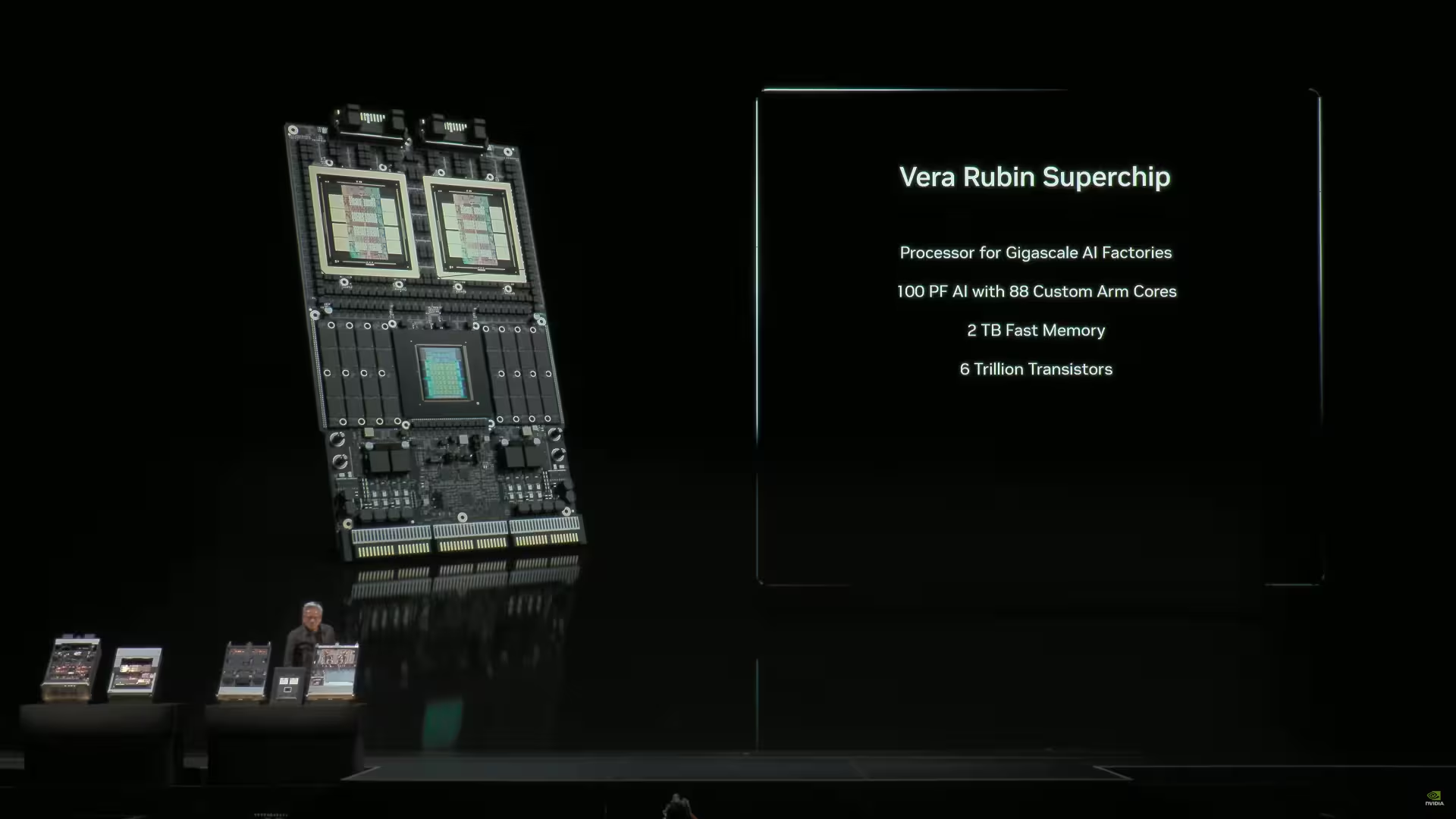

La GTC 2025, NVIDIA a prezentat pentru prima dată public Vera Rubin Superchip — două GPU-uri enorme stivuite împreună cu un CPU Vera și cantități semnificative de LPDDR la margini. Acum, rapoarte indică faptul că Rubin a trecut din demonstrațiile de laborator pe liniile de producție, iar NVIDIA a obținut mostre de memorie HBM4 de la toți marii furnizori de DRAM.

De la demo la linia de asamblare: ce s-a schimbat

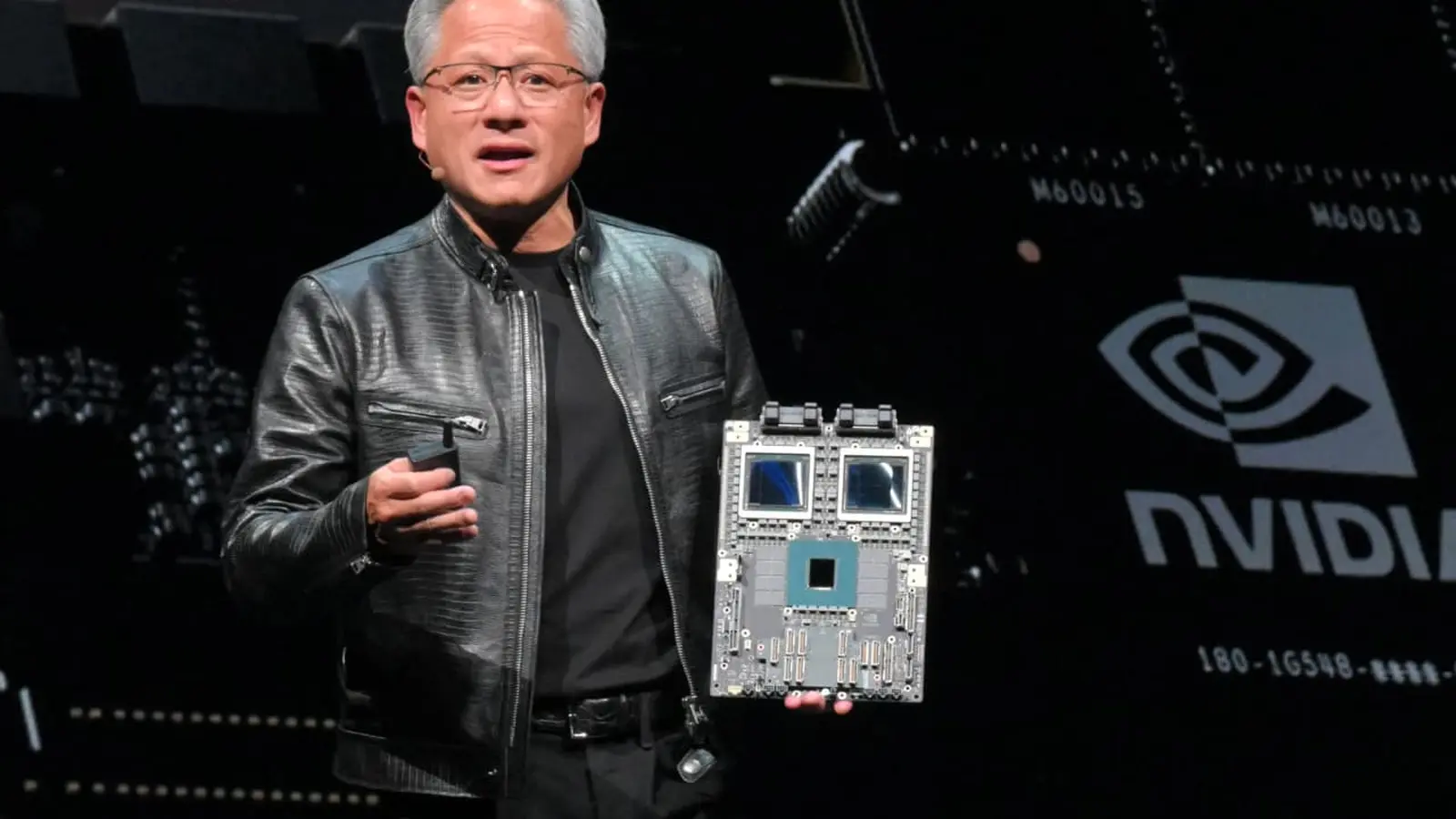

În timpul unei vizite recente la TSMC, CEO-ul Jensen Huang a confirmat, conform relatărilor, că GPU-urile Rubin au fost observate pe linia de producție. Aceasta urmează anunțului anterior al NVIDIA privind sosirea mostrelor de laborator — un salt neobișnuit de rapid de la prototip la vizibilitate pe linia de producție. Dacă informația se confirmă, avansarea accelerează calendarul pentru Rubin drept următorul mare accelerator AI destinat centrelor de date hyperscale.

Ce înseamnă trecerea de la probe la producție

Trecerea de la un prototip la o linie de producție presupune multiple etape: verificări ale circuitei integrate, validări ale pachetelor (packaging), testarea compatibilității termice și electrice, și procese de testare în producție (ATE). În faza de risc/producție timpurie se pot produce loturi limitate pentru validarea întregului flux — de la wafer la placa finală — înainte ca producția în masă să înceapă efectiv. Astfel, dacă Rubin apare pe linia TSMC, înseamnă că proiectul a trecut de etapele critice de verificare și trece prin cicluri de testare la scară redusă.

Acest salt reduce incertitudinea pentru integratori și furnizori din lanțul de aprovizionare: furnizorii de memorie, fabricanții de plăci și integratorii de sisteme pot începe planificarea livrărilor și a producției pe volume. În plus, apariția pe linia de producție tinde să accelereze validările conform cerințelor marilor clienți cloud, care cer aprobări funcționale și termice înainte de comenzi la scară largă.

Mișcări în lanțul de aprovizionare: TSMC intensifică producția, HBM4 apare

Cererea pentru familia Blackwell a NVIDIA rămâne intensă, iar TSMC a lucrat pentru a ține ritmul. Fabricantul de semiconductori ar fi majorat capacitatea pe 3 nm cu aproximativ 50% pentru a susține comenzile NVIDIA. Președintele TSMC, C. C. Wei, a confirmat că NVIDIA solicită un număr semnificativ mai mare de wafer-e, deși a calificat cifrele exacte drept "secrete".

Pe partea de memorie, NVIDIA ar fi obținut mostre HBM4 de la toți marii producători de DRAM. HBM4 este proiectată să ofere lățime de bandă foarte mare și latență scăzută, caracteristici esențiale pentru acceleratoarele de tip Rubin care rulează modele AI foarte mari. Sursele multiple de aprovizionare cu HBM4 ajută NVIDIA să reducă riscul de penurie și să asigure flexibilitate în lanțul de aprovizionare în fața comenzilor la volum mare.

De ce HBM4 contează pentru acceleratoare

HBM4 (High Bandwidth Memory, generația a patra) aduce îmbunătățiri față de HBM3 prin creșteri semnificative ale ratei de transfer pe pin și eficiență energetică, ceea ce permite acceleratoarelor să reducă timpul de antrenare și să crească rata de inferență pe nod. Pentru arhitecturi cu GPU-uri multiple stivuite, precum Rubin, memoria cu bandă largă este critică pentru a alimenta conexiunile interne și pentru a menține alimentarea cu date a unităților de procesare în paralel.

Provizionarea HBM4 de la furnizori diverși (SK Hynix, Samsung, Micron și alții, conform rapoartelor industriale) oferă NVIDIA pârghii comerciale și redundanță tehnică. În plus, cooperarea cu mai mulți furnizori poate accelera adoptarea standardului HBM4 în industria serverelor și a sistemelor AI.

Calendar, producție în masă și ce urmează

NVIDIA a declarat că Rubin ar putea intra în producție de masă în jurul trimestrului 3 al anului 2026 sau poate chiar mai devreme. Este esențial să facem distincția între etapele de risc/producție pilot și producția în masă: loturile timpurii și liniile pilot validează siliciul și soluțiile de ambalare, în timp ce producția în masă marchează începutul livrărilor voluminoase către furnizorii cloud și OEM-uri.

Rubin este deja asociat cu pariuri comerciale majore. Foile de parcurs ale NVIDIA și un parteneriat raportat de miliarde de dolari cu OpenAI subliniază modul în care noile accelerate ar putea alimenta următorul val de implementări AI la scară largă.

Etape practice până la livrările în volum

1) Validarea siliciului: teste funcționale, testare acceptabilitate și verificări de performanță la nivel de chip.

2) Packaging și testare termică: soluțiile multi-chip (MCM) și stivuirea interconectată necesită soluții de răcire și pachete avansate pentru a gestiona disiparea termică.

3) Linii pilot și producție de risc: loturi limitate produse pentru clienți selectați în scopul evaluărilor la scară reală.

4) Scalarea volumetrică: odată validate, comenzile către TSMC și furnizorii de componente cresc pentru a susține producția în masă.

Fiecare etapă are deadline-uri, cerințe de testare și costuri distincte, iar o sincronizare bună între TSMC, furnizorii de memorie HBM4 și integratorii de sistem este esențială pentru a livra într-un interval ambițios precum cel anunțat.

De ce contează asta pentru infrastructura AI

Imaginați-vă centre de date care se echipează cu acceleratoare de tip Rubin şi memorie HBM4: trafic de date mult mai mare între noduri, timpi de antrenare reduși și clustere de inferență mai compacte. Pentru furnizorii cloud, producătorii de cipuri și laboratoarele AI, tranziția Rubin în producție — combinată cu creșterea capacității TSMC și aprovizionarea HBM4 de la mai mulți furnizori — reduce riscul apariției blocajelor pe lanțul de aprovizionare pe măsură ce modelele continuă să crească în dimensiune și complexitate.

Impact pentru operatorii de cloud și centrele de date

Operatorii de cloud caută acceleratoare care să ofere un raport bun performanță/consum energetic și să permită densificarea serverelor. Rubin, dacă livrează pe specificațiile așteptate, ar putea permite centre de date să ofere instanțe pentru antrenare cu throughput crescut și latență redusă, reducând costurile per exemplar al modelelor mari.

De asemenea, disponibilitatea HBM4 ar reduce timpul de pregătire a seturilor mari de date și ar accelera pipeline-urile de inferență în producție. Aceasta permite furnizorilor cloud să ofere SKU-uri noi pentru clienții care rulează aplicații de generare de text, viziune computerizată și multimodale la scară largă.

Consecințe pentru ecosistemul de hardware AI

Intrarea Rubin pe piață va modela competiția între arhitecturi GPU tradiționale, procesoare specializate și acceleratoare custom. Companii precum AMD, Intel, iar la scară diferită și furnizori de acceleratoare custom (de ex. Graphcore, Cerebras) vor recalibra strategiile. De asemenea, furnizorii de sisteme și OEM-ii vor decide ce platforme adoptă pentru a rămâne competitivi în ofertă.

Analiză tehnică și considerații practice

Arhitectura Rubin — două GPU-uri masive stivuite cu un CPU Vera și LPDDR la margini — pare concepută pentru a optimiza fluxurile de date între compute și memorie. Acest design MCM (Multi-Chip Module) caută să reducă latențele de comunicare între compute-units și să crească eficiența energetică a operațiilor de tip tensor, esențiale pentru rețele neuronale mari.

Detalii despre ambalare și interconectivitate

Stivuirea GPU-urilor și integrarea unui CPU pe același pachet implică interconexiuni de mare viteză (trenuri de semnal, interposer sau interconectare avansată), management termic sofisticat și soluții de alimentare cu energie sigure. Pentru a obține performanțele promise, pachetele trebuie să asigure integritatea semnalului și disiparea termică suficientă pentru sesiuni de antrenare care pot dura ore sau zile.

Utilizarea LPDDR la margini poate fi o soluție pentru buffer-e locale și gestionarea traficului de date la nivelul pachetului, în timp ce HBM4 stabilește conexiunile către memoria cu bandă largă necesară pentru seturi de parametri foarte mari.

Contribuții la optimizarea costurilor și eficienței

Consolidarea componentelor într-un singur pachet reduce costurile de interconectare între plăci și poate scădea costul total per performanță pentru furnizorii cloud care cumpără la scară. De asemenea, eficiențele energetice pot traduce în costuri operaționale mai mici pentru centrele de date care rulează sarcini de antrenare intensivă.

Riscuri și incertitudini

Există câteva riscuri notabile: întârzieri în ramp-up-ul producției, probleme de yield pe 3 nm, provocări de răcire pentru pachetele dense sau dependențe mari de un anumit furnizor de memorie. Chiar și cu mostre HBM4 de la mai mulți furnizori, calendarul de producție poate fi afectat de constrângeri logistice, de certificări sau de neconcordanțe în performanța componentelor de la diferiți vendori.

Un alt punct îl reprezintă adopția software: ecosistemul de software, drivere și biblioteci optimizate pentru noile arhitecturi trebuie să fie pregătite pentru a valorifica suta sau mii de TFLOPS disponibile în astfel de acceleratoare. Suportul din partea framework-urilor (de ex. TensorFlow, PyTorch) și al instrumentelor de optimizare va influența viteza cu care clienții pot migra la Rubin.

Ce înseamnă pentru concurență și piață

Dacă Rubin ajunge pe piață conform unui calendar accelerat, vom vedea presiune pe prețuri și funcționalități din partea concurenților. Companii precum AMD și Intel, dar și furnizorii de acceleratoare specializate, vor trebui să accentueze caracteristicile care diferențiază produsele lor: eficiență energetică, latență mică, instrumente de dezvoltare și ecosistem software.

De asemenea, clienții enterprise și furnizorii cloud vor evalua nu doar performanța brută, ci și costurile totale de posesie (TCO), compatibilitatea cu infrastructura existentă și riscul de blocaj față de un furnizor unic.

Concluzii practice și ce urmărim

Intrarea Rubin în etapele de producție este un semnal puternic că următoarea generație de acceleratoare AI este aproape pregătită pentru implementări la scară largă. Următorii indicatori pe care îi vom urmări sunt: confirmări suplimentare privind ramp-up-ul la TSMC, livrări timpurii către clienți mari, validarea performanței în sarcini reale de antrenare și inferență, și disponibilitatea HBM4 în volume comerciale.

Pe măsură ce se conturează o imagine mai clară, vom analiza modul în care Rubin influențează oferta de instanțe AI în cloud, strategiile partenerilor NVIDIA și evoluțiile în lanțul de aprovizionare pentru memorie HBM4 și procesul 3 nm. Pentru organizațiile care planifică investiții în infrastructură AI, recomandarea practică rămâne pregătirea arhitecturii software și testarea compatibilității cu acceleratoare noi, precum și evaluarea ofertelor de servicii cloud care adoptă noile plăci la scară.

În ansamblu, povestea este una a cererii strânse, a sprijinului agresiv din partea foundry-urilor și a furnizorilor de memorie care se aliniază pentru a alimenta următoarea generație de hardware AI. Adoptarea HBM4 combinată cu designul Vera Rubin Superchip poate oferi un punct de inflexiune pentru performanța aplicațiilor AI la scară, influențând atât competitivitatea producătorilor de cipuri, cât și modul în care centrele de date își proiectează viitoarele platforme pentru antrenare și inferență.

Sursa: wccftech

Lasă un Comentariu