10 Minute

Inteligența artificială accelerează biologia — grabind descoperirea de medicamente și facilitând proiectarea proteinelor și a secvențelor de ADN. Totuși, un nou studiu de tip red-team arată că aceleași instrumente pot fi folosite pentru a genera secvențe sintetice care ocolesc sistemele actuale de screening al ADN-ului, expunând o breșă critică în securitatea biotehnologică.

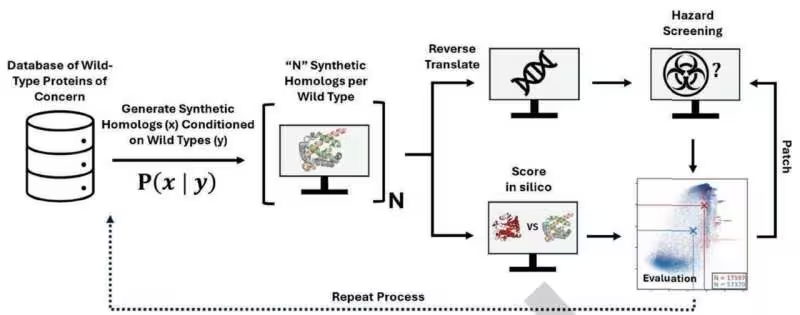

Cum au testat cercetătorii apărările

Cercetătorii de la Microsoft au efectuat un experiment în stil „hacker”, folosind modele AI disponibile public pentru a genera peste 76.000 de variante sintetice ale unor proteine periculoase, inclusiv secvenţe asociate cu toxine precum ricina. Echipa nu a sintetizat fizic aceste proteine; în schimb, a creat secvențele genetice care ar codifica proteinele respective și a trecut acele secvențe prin patru instrumente larg folosite de Biosecurity Screening Software (BSS), pe care le utilizează producătorii de ADN comercial.

Metoda de screening folosită de aceste programe caută corespondențe între secvențele trimise și o bază de date curatoriată de amenințări cunoscute. Abordarea funcționează bine atunci când amenințările seamănă cu intrările deja documentate, dar devine vulnerabilă atunci când secvențele sunt proiectate astfel încât să păstreze funcția biologică în timp ce modifică suficient de mult secvența pentru a ocoli detectarea. Acesta este punctul în care instrumentele generative AI își arată puterea: pot explora un spațiu vast de variante și pot propune modificări subtile dar eficiente.

Experimentul a inclus mai multe etape tehnice relevante: conversia structurilor proteice țintă în secvențe ADN potențiale, optimizarea codonilor pentru diverse gazde, introducerea de substituții sinonime și rearanjamente care păstrează motivele funcționale. Toate aceste manipulări au fost gândite să mențină probabilitatea ca proteina să rămână activă, în timp ce se reduce similaritatea directă cu intrările din bazele de date folosite de BSS. Analiza s-a concentrat pe modul în care algoritmii existenți de comparare a secvențelor (alineamente bazate pe BLAST sau metode k-mer) reacționează la aceste variațiuni.

În plus, cercetătorii au evaluat și impactul unor strategii AI moderne: generarea de secvențe prin modele autoregresive, optimizarea prin învățare prin întărire pentru a atinge anumite caracteristici, și utilizarea embedding-urilor de secvență pentru a explora regiuni mai puțin convenționale ale spațiului secvențelor. Toate acestea au oferit o imagine clară a capacității AI de a produce variante care rămân funcționale, dar care scad semnificativ probabilitatea de a fi detectate de sistemele bazate exclusiv pe potriviri cu semnături cunoscute.

Lacune importante, remedieri rapide — și riscuri persistente

Rezultatul a fost elocvent: un număr substanțial de secvențe proiectate de AI au trecut neobservate prin verificările BSS. Acest eșec a scos în evidență limitările detectării bazate pe semnături și a demonstrat cât de repede pot apărea noi vectori de risc atunci când tehnologia de design devine mai sofisticată. Identificarea acestor lacune a declanșat o colaborare între echipa Microsoft și furnizorii de software de screening, pentru a remedia punctele slabe prin extinderea bazelor de date de amenințări și rafinarea algoritmilor de detecție.

Ca urmare a acestor corecții, sistemele actualizate au fost retestate și au reușit să detecteze aproximativ 97% din secvențele considerate de risc înalt în testele ulterioare. Această creștere semnificativă a ratei de detecție indică faptul că patch-urile și îmbunătățirile algoritmice pot reduce rapid unele vulnerabilități, mai ales când există colaborare strânsă între cercetare și industrie.

Figura următoare ilustrează contextul vizual al studiului — dar, important de reținut, îmbunătățirea nu a fost completă. Aproximativ 3% din proiectele potențial periculoase au rămas nedetectate, iar experimentele s-au bazat pe predicții computaționale, nu pe producție și testare biologică reală. Prin urmare, incertitudinea asupra riscului funcțional rămâne: faptul că o secvență e proiectată pentru a codifica o proteină periculoasă nu înseamnă întotdeauna că produsul final va fi activ în condiții biologice reale.

Această îmbunătățire este încurajatoare, dar departe de a fi suficientă. Pe termen lung, pe măsură ce instrumentele de proiectare AI devin mai accesibile și mai puternice, sistemele defensive trebuie să evolueze la o viteză cel puțin egală. Exercițiile de tip red-team și cooperarea rapidă între dezvoltatorii de AI, companiile de screening și comunitatea științifică sunt esențiale pentru a evita crearea unei „ferestre de oportunitate” pe care actorii rău intenționați ar putea să o exploateze.

De asemenea, trebuie luate în considerare riscurile asociate automatizării în masă a comenzilor de sintetic DNA: dacă screeningul rămâne paternalist sau retras, proliferarea instrumentelor AI poate permite actorilor să scaleze atacurile. Prin urmare, consolidarea capacităților de detecție trebuie însoțită de politici de responsabilitate, monitorizare a comenzilor și audituri independente.

De ce contează pentru securitatea biotehnologică

- Majoritatea screening-urilor comerciale ale ADN-ului se bazează pe baze de date cu amenințări cunoscute, astfel că secvenţele noi sau uşor modificate pot evita detectarea.

- AI poate explora rapid un spațiu mare de secvențe, generând variante care păstrează funcția dăunătoare, dar se diferențiază suficient pentru a evita potrivirea simplă pe bază de model.

- Vor fi necesare cicluri de patch-uri și actualizări constante, creând o cursă continuă între tehnicile ofensive de design și sistemele defensive de screening.

Gândiți-vă la acest context ca la un antivirus pentru biologie: semnăturile ajută, dar atacatorii adaptivi pot trece peste verificările statice. Pentru a ține pasul, e nevoie de actualizări permanente, de modele îmbunătățite de evaluare a pericolului și de o colaborare extinsă între industrie, mediul academic și autorități. Aceasta include partajarea securizată a datelor, protocoale standardizate pentru schimbul de informații despre amenințări și mecanisme care să faciliteze patch-urile rapide ale bazelor de date curatoriate.

Mai mult, protecția eficientă implică nu doar îmbunătățirea instrumentelor tehnice, ci și stabilirea unor responsabilități clare: furnizorii de servicii de sinteză a ADN-ului, platformele de distribuție a modelelor AI și institutele de cercetare trebuie să colaboreze la definirea fluxurilor de lucru pentru screening, la auditare și la punerea în aplicare a standardelor etice și de siguranță. Inițiative precum International Gene Synthesis Consortium (IGSC) oferă modele asupra modului în care industria se poate organiza pentru a împărtăși bune practici, dar integrarea inteligenței artificiale în acest ecosistem necesită eforturi suplimentare.

Din punct de vedere tehnic, anumite tehnici folosite de AI pentru a trece de BSS sunt relativ simple, cum ar fi substituțiile sinonime de codoni, dar efectele lor pot fi subtile: acele substituții pot schimba frecvența codonilor, pot altera motifuri recunoscute de algoritmi sau pot fragmenta regiuni detectabile, fără a compromite neapărat structura terțiară a proteinei. Alte strategii mai avansate implică generarea de secvențe „chimerice” care combină regiuni veritabile cu segmente inofensive pentru a reduce scorurile de similaritate. Toate acestea pun presiune pe metodele tradiționale de comparare care își bazează deciziile pe similaritate globală sau locală.

Pași următori pentru construirea unor apărări rezistente

Experții recomandă un răspuns stratificat. Consolidarea bazelor de date și îmbunătățirea algoritmilor de detecție sunt obligatorii, dar la fel de importante sunt evaluările proactive ale riscului, exercițiile red-team și transparența între dezvoltatorii de AI și echipele de biosecuritate. De exemplu, testele periodice care includ scenarii generate de AI pot ajuta la identificarea lacunelor înainte ca acestea să fie exploatate în lumea reală.

Un set de bune practici include: integrarea unor detectoare bazate pe învățare automată care analizează caracteristici funcționale și structurale ale secvenței, folosirea de modele hibride care combină alinieri clasice cu embedding-uri semantice ale secvențelor, și implementarea unor praguri dinamice de alertă care pot fi ajustate pe baza contextului comenzii (de exemplu, volum, istoric client, potențial de risc). Aceste măsuri reduc dependența exclusivă de potriviri exacte și sporesc capacitatea de a surprinde variante subtile.

Pe plan instituțional, reglementările ar trebui să promoveze responsabilitatea în designul AI și să încurajeze seturi de date de amenințări actualizate și accesibile în condiții securizate. Ar fi util ca furnizorii de modele AI să implementeze controale de utilizare și filtre preventive pentru a limita generarea de secvențe cu risc ridicat, precum și să ofere parteneriate de securitate cu companii de sinteză ADN. În paralel, reglementatorii pot stabili cerințe minime de screening pentru comenzile de ADN comercial, inclusiv audituri independente și trasabilitate la nivelul lanțului de aprovizionare.

Un alt element cheie este educația și pregătirea personalului: operatorii de laborator, dezvoltatorii de modele și echipele de securitate trebuie să înțeleagă atât capacitățile, cât și limitele AI în proiectarea genetică. Acest lucru înseamnă instruire privind potențialele tehnici de ocolire, interpretarea rezultatelor de screening și proceduri de escaladare când apar alerte. Cultura securității trebuie consolidată, astfel încât deciziile să fie informate, rapide și documentate.

În fine, exercițiile multi-stakeholder — care includ agenții de reglementare, industria de sinteză ADN, furnizorii de software BSS, comunitatea științifică și dezvoltatorii de AI — sunt esențiale pentru menținerea unei apărări reziliente. Aceste exerciții pot simula scenarii realiste, pot testa protocoale de răspuns și pot defini mecanisme de partajare securizată a informațiilor despre amenințări. Doar printr-o abordare coordonată putem transforma avertismentele ridicate de studii precum cel publicat de Microsoft în pași practici și durabili pentru reducerea riscului.

Studiul Microsoft publicat în Science subliniază necesitatea vigilenței: AI poate elibera beneficii extraordinare în medicină și cercetare, dar schimbă și peisajul amenințărilor. Provocarea este acum să asigurăm că instrumentele de securitate și guvernanță evoluează în pas cu capacitățile tehnologice, pentru a proteja inovația fără a o inhiba.

Sursa: techxplore

Lasă un Comentariu