10 Minute

Introducere: întrebarea de bază

Echipa de cercetare a Apple a pus o întrebare simplă, dar neliniștitoare: ce își doresc, în realitate, oamenii de la agenții AI atunci când aceștia îi ajută în activitățile cotidiene? Răspunsul nu este ordonat. Este complex, uman și plin de compromisuri între autonomie, control și claritate.

Acest articol traduce și extinde concluziile lucrării „Mapping the Design Space of User Experience for Computer Use Agents” și extrage recomandări practice pentru designeri, dezvoltatori de aplicații și echipe UX care construiesc agenți AI sau interfețe conversaționale. Vom explica metodologia, constatările principale, implicațiile pentru designul UX și pași concreți pentru implementare și evaluare.

Studiul: ce au analizat cercetătorii

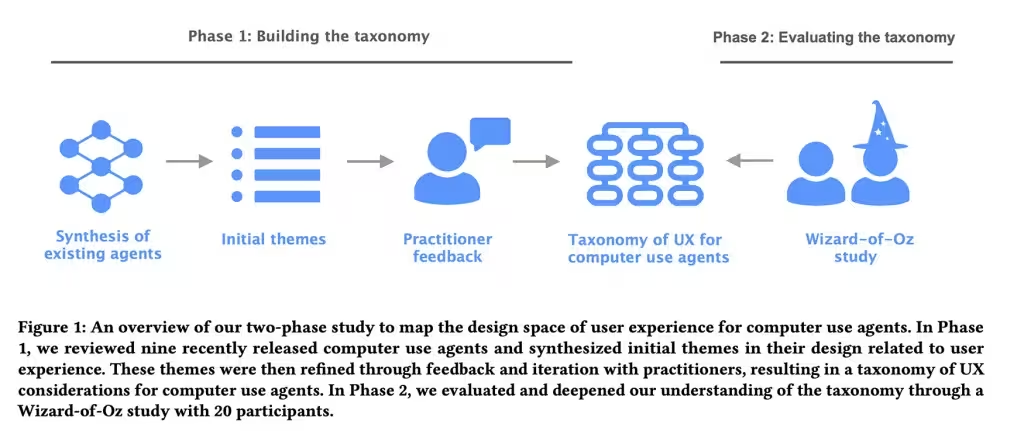

În lucrare au fost examinați nouă agenți existenți — denumiri precum Claude Computer Use Tool, Adept, OpenAI Operator, AIlice, Magentic-UI, UI-TARS, Project Mariner, TaxyAI și AutoGLM — pentru a cartografia modul în care aceste sisteme își prezintă capabilitățile, gestionează erorile și invită controlul utilizatorului. Prima fază a fost observatoare și clasificatoare: opt specialiști în UX și AI au sintetizat peisajul într-un cadru structurat, alcătuit din patru categorii principale, 21 de subcategorii și 55 de caracteristici de design concrete.

Caracteristicile acoperite au variat de la modurile prin care utilizatorii introduc sau validează inputul, la gradul de transparență al acțiunilor agentului, până la nivelurile de control pe care utilizatorul le păstrează și la modul în care sunt modelate așteptările mentale (mental models). Această primă analiză pune bazele pentru o arhitectură decizională: ce ar trebui afișat, când și cum, pentru a echilibra eficiența cu siguranța și încrederea.

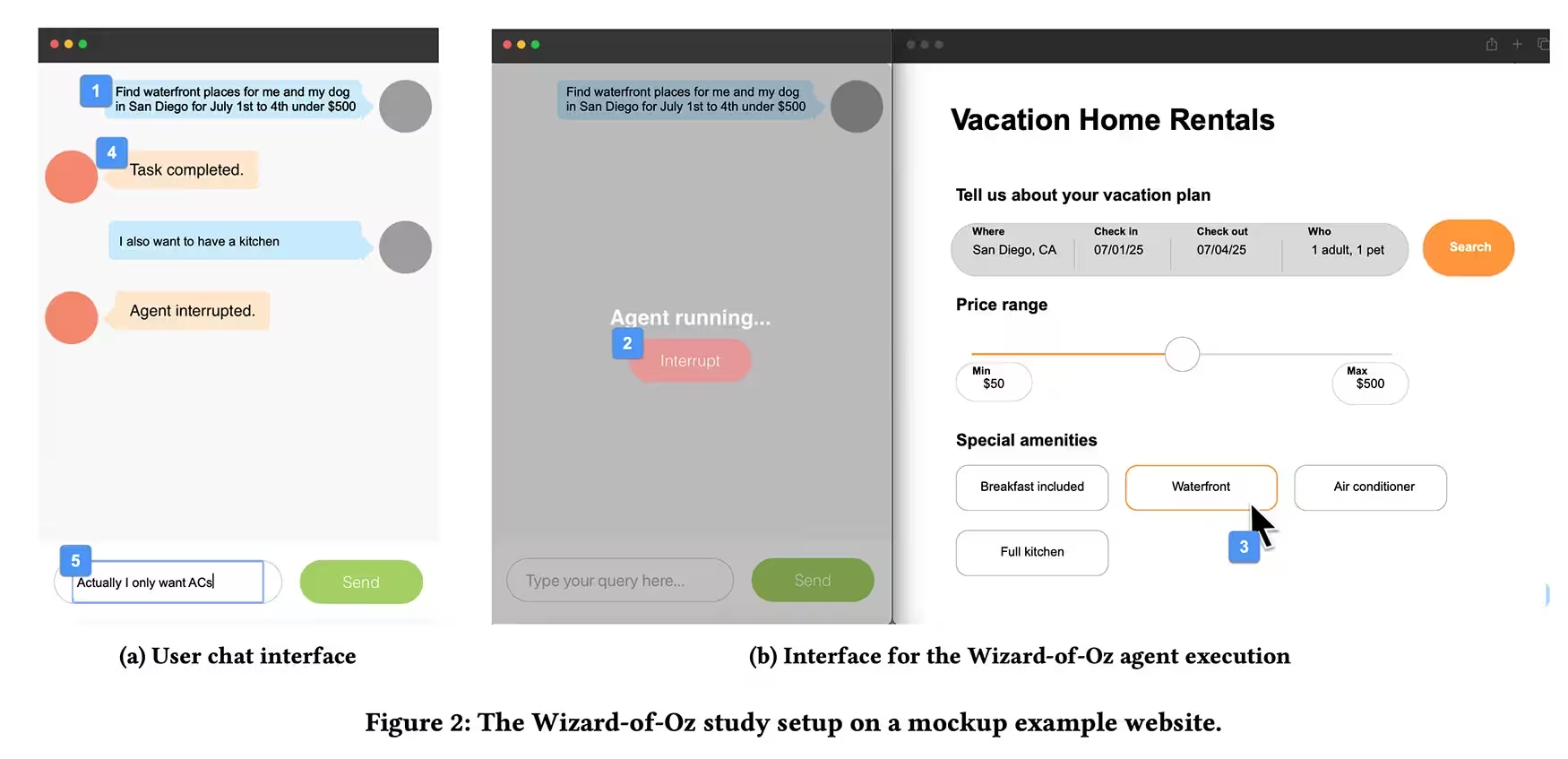

Metodologie: experimentul „Wizard of Oz”

Pentru a observa comportamentul real al oamenilor într-un context controlat, echipa a rulat un experiment de tip Wizard of Oz. Douăzeci de participanți cu experiență prealabilă în folosirea asistenților AI au primit sarcina de a delega activități — rezervarea unei vacanțe, cumpărături online, modificări de cont — printr-o interfață de tip chat, în timp ce un cercetător, aflat în afara câmpului vizual, controla efectiv agentul cu tastatura și mouse-ul.

Participanții puteau introduce comenzi, observa acțiunile afișate de interfață și apăsa un buton de oprire pentru a întrerupe agentul. Cercetătorii au inclus deliberat erori și întreruperi neașteptate în unele scenarii, pentru a analiza reacțiile utilizatorilor când agentul greșea, făcea presupuneri sau devia de la așteptări.

Sarcini simulate

- Rezervarea unei vacanțe (compararea ofertelor, selectarea zborului și hotelului, rezervare)

- Cumpărături online (adăugarea la coș, alegerea metodei de plată, finalizare achiziție)

- Schimbări de cont (modificarea setărilor, resetare parole, actualizare informații personale)

Măsurători și proceduri

- Observație calitativă a limbajului, comportamentului și intervențiilor utilizatorilor.

- Înregistrarea momentelor când participanții au folosit butonul de stop sau au cerut clarificări.

- Introducerea deliberată a erorilor: presupuneri greșite, pași lipsă, acțiuni automate neanunțate.

Acest design experimental a permis echipei să colecteze date despre preferințele reale ale utilizatorilor, despre pragurile de toleranță la eroare și despre tiparele de încredere pe care le construiesc interfețele conversaționale într-un mediu de utilizare obișnuit.

Ce au descoperit: pattern-uri și preferințe

Rezultatele au conturat un set clar de preferințe și limite comportamentale. În linii mari, oamenii vor vizibilitate asupra a ceea ce agentul face, dar nu vor să micromanageze fiecare click. Demonstrațiile scurte de intenție și confirmările ocazionale liniștesc utilizatorii; tăcerea totală a agentului alimentează suspiciunea; automatizarea abruptă fără explicații produce aceeași reacție negativă.

Vizibilitate versus micromanagement

Participanții au arătat că preferă mecanisme care oferă vizibilitate progresivă: vizualizări ale intențiilor agentului (ce urmează să facă), pași vizibili (o listă de acțiuni propuse) și joncțiuni de confirmare pentru acțiuni cu consecințe reale. Această abordare reduce frustrarea deoarece oferă control și predictibilitate, fără a transforma experiența într-un proces detaliat și obositor.

Încrederea: fragilă ca sticla

Încrederea se comportă ca sticla: fragilă și se fisurează rapid. Asumpțiile ascunse sau erorile aparent minore erodează încrederea mult mai repede decât performanța fluentă o construiește. Când agentul deviază de la script sau se confruntă cu ambiguitate, participanții preferau ca acesta să pună o întrebare în loc să ghicească și să acționeze. Această preferință rămânea valabilă chiar când confirmările suplimentare erau percepute ca ușor enervante — mesajul implicit: mai bine sigur decât păcălit.

Diferența între începători și experți

Utilizatorii novici cer explicații pas cu pas și puncte de verificare blânde când acțiunile au consecințe tangibile — cumpărături, modificări de cont sau orice lucru care nu poate fi anulat cu ușurință. Pe de altă parte, experții preferă un agent care acționează mai mult ca un coleg de încredere decât ca un asistent precaut; ei acceptă predicții și automatizări mai agresive dacă rezultatele sunt rapide și consistente.

Recomandări de design

Proiectați agenți AI care își ajustează nivelul de transparență și control în funcție de sarcină și de experiența utilizatorului.

Pentru designeri și dezvoltatori, implicațiile sunt practice și concrete. Mai jos sunt recomandări aplicabile pentru interfețele agenților AI, care pot fi adoptate imediat în procesele de proiectare și testare:

Principii generale

- Arătați intenția: afișați ce urmează să facă agentul înainte de a acționa.

- Progres vizibil: oferți pași care permit utilizatorilor să vadă stadiul unei operațiuni lungi.

- Oprire și corectare ușoară: integrați un buton clar de stop/undo și fluxuri pentru modificarea deciziilor.

- Adaptivitate: reglați cantitatea de explicație în funcție de familiaritatea utilizatorului (profil adaptiv sau setări explicite).

- Confirmări proporționale: folosiți verificări suplimentare doar pentru acțiuni cu risc sau cost real.

Pattern-uri de interacțiune concrete

- Preview de acțiune: înainte de a finaliza, prezentați un sumar clar (ex.: „Voi rezerva zborul A și hotelul B. Confirmi?”).

- Checkpoints soft: după fiecare etapă critică, propuneți o confirmare scurtă, fără a bloca fluxul, dar oferind o șansă de corectare.

- Explicații explicite la cerere: furnizați un buton „De ce a făcut asta?” pentru transparență contextuală.

- Fallbackuri sigure: când există ambiguitate, agentul trebuie să ceară clarificări și nu să ghicească.

Măsurare și evaluare

Pentru a valida aceste decizii de design, folosiți măsurători mixte:

- Metrice UX: timp până la finalizare, rate de intervenție manuală, frecvența folosirii butonului de stop, scoruri de satisfacție.

- Analiză calitativă: înregistrări ale interacțiunii, comentarii post-task, interviuri despre fazele în care utilizatorii au simțit pierderea controlului.

- Indicatori de încredere: măsurați degradarea sau creșterea încrederii în funcție de erorile observate și de mecanismele de corecție.

Detalii tehnice și implementare

Pentru echipele tehnice, integrarea acestor principii implică decizii asupra arhitecturii sistemului și a modalităților de control al fluxului decizional al agentului. Cateva recomandări tehnice:

Arhitectură și flux

- Separarea stratului de intenție de cel de execuție: agenții ar trebui să genereze o reprezentare clară a pașilor intenționați (plan) pe care UI-ul să o poată afișa.

- Pipeline de validare: pentru acțiuni sensibile, introduceți etape automate de validare și posibilitatea intervenției umane (human-in-the-loop).

- Jurnale de acțiuni (audit logs): păstrați un istoric clar al acțiunilor propuse și executate pentru debuggere, asistență și transparență.

Modele și explicații

Explicabilitatea (explainability) nu înseamnă întotdeauna explicarea matematică a deciziilor modelului; adesea este mai eficient să oferiți explicații pragmatic-contextuale: „Am ales această opțiune pentru că se potrivește criteriilor tale: preț, durată și scoruri de calitate”. Aceste explicații pot fi generice, dar trebuie să fie relevante și succinte.

Control adaptiv

Implementați un strat de preferințe utilizator care memorează nivelul de intervenție acceptat: utilizatorii pot alege moduri precum „expert”, „standard” sau „ghidat”. Agentul folosește acest profil pentru a regla frecvența confirmărilor, gradul de automatizare și cantitatea de informații afișate.

Impact asupra produsului și afacerii

Adoptarea acestor principii are implicații directe pentru retenția utilizatorilor și pentru percepția mărcii. Agenții care oferă transparență și control cresc satisfacția și reduc frustrarea, ceea ce poate conduce la o utilizare mai frecventă a funcțiilor automate și la un cost mai mic de suport.

Totuși, există compromisuri: prea multe confirmări pot încetini fluxurile și pot feri utilizatorii avansați. Cheia este testarea continuă, descoperirea pragurilor tolerabile și adaptarea interfeței în timp real sau prin configurări profilate.

Exemple practice și scenarii

Iată cum pot fi aplicate aceste recomandări în scenarii concrete:

Rezervare de vacanță

Agentul prezintă un plan în trei pași: (1) selectare opțiuni, (2) verificare prețuri și disponibilitate, (3) finalizare rezervare. La pasul 2 apare o casetă cu sumar și un buton „Confirmă rezervarea”. Dacă detectează o ambiguitate (ex.: preferințe conflictuale), agentul întreabă: „Preferi zbor direct sau cu escală?”

Cumpărături online

Pentru achiziții, introduceți o confirmare suplimentară pentru metodele de plată noi sau sume mari. O funcționalitate de „review cart” arată exact ce se va plăti și oferă opțiunea de a anula rapid.

Limitări și direcții viitoare de cercetare

Studiul are limitări: eșantionul de 20 de participanți oferă date valoroase calitative, dar generalizările la populații mai largi necesită studii la scară mai mare. De asemenea, scenariile simulate nu capturează toate complexitățile mediilor reale, cum ar fi utilizatorii cu nevoi speciale sau interacțiuni pe dispozitive multiple.

Direcții viitoare includ evaluarea pe termen lung a încrederii, efectele personalizării agresive a transparenței și explorarea automatizărilor în fluxuri colaborative unde mai mulți utilizatori influențează deciziile agentului.

Concluzie

Nu este vorba doar despre modele mai inteligente, ci despre interacțiuni mai inteligente. Alegerile mici — o confirmare aici, un pas vizibil acolo, o pauză la momentul potrivit când agentul ezită — vor decide pe termen scurt dacă oamenii vor avea încredere în automatizare sau o vor dezactiva. Pentru designeri și dezvoltatori, provocarea practică este să construiască sisteme care sunt atât eficiente, cât și explicabile, și să folosească cercetarea UX pentru a modela gradul optim de control și transparență.

Implementând o arhitectură care separă intenția de execuție, integrând mecanisme clare de stop și undo, și testând adaptiv nivelul de explicație, echipele pot crea agenți AI care nu doar rezolvă sarcini, ci și construiesc încredere durabilă cu utilizatorii.

Sursa: smarti

Lasă un Comentariu