8 Minute

Samsung se poziționează ca un furnizor major de memorie pentru serverele AI de nouă generație ale Nvidia, angajându-se să livreze jumătate din noile module DRAM SOCAMM2 de care Nvidia va avea nevoie în 2026. Această mișcare urmează unui an intens de rafinare a tehnologiilor Samsung pentru DRAM de înaltă performanță și HBM.

De ce contează victoria Samsung pentru SOCAMM2

După ce a ratat o parte semnificativă din boom-ul memoriei pentru AI în anul precedent, Samsung a înregistrat îmbunătățiri notabile ale randamentelor și performanței pe liniile sale avansate de DRAM. Compania a trimis deja mostre HBM4 către Nvidia pentru testare finală și a confirmat planurile de a furniza aproximativ 50% din modulele Small Outline Compression Attached Memory Module 2 (SOCAMM2) pe care Nvidia le anticipează pentru anul următor.

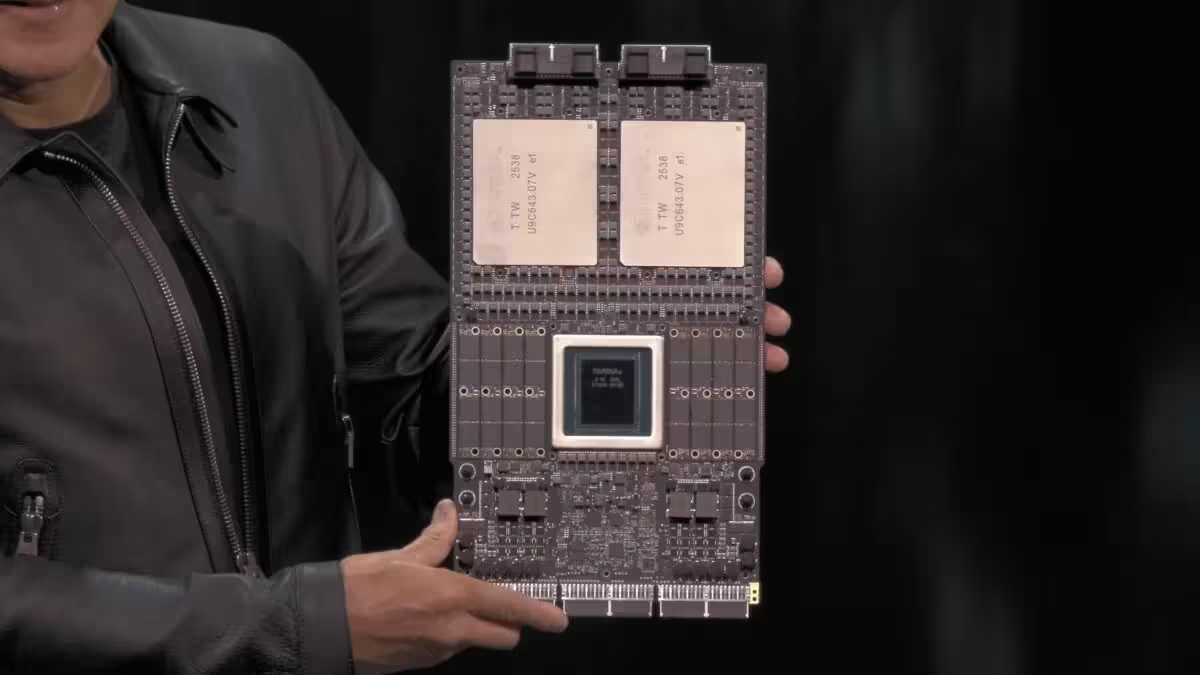

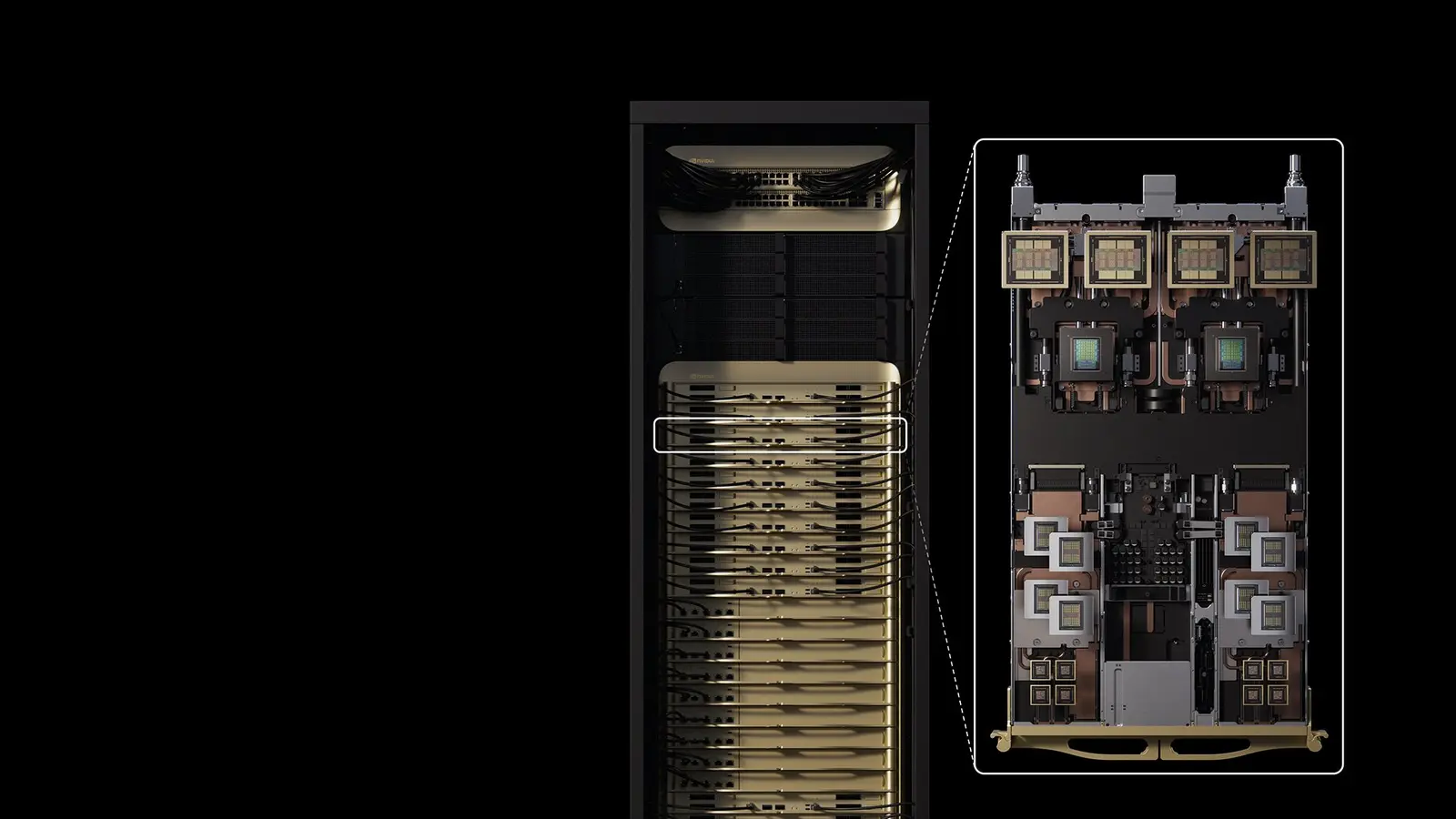

SOCAMM2 reprezintă, practic, un pachet de memorie dens, optimizat pentru servere, care integrează mai multe cipuri LPDDR pe un singur substrat. Această arhitectură simplifică procesele de upgrade și reduce amprenta fizică a memoriei în centrele de date AI. Platformele Vera ale Nvidia, de exemplu, dispun mai multe module SOCAMM2 în jurul procesorului Vera pentru a alimenta GPU-urile Rubin cu fluxuri de date cu lățime de bandă ridicată.

Micron a condus prima rundă a adopției SOCAMM în 2025, dar Samsung — împreună cu SK Hynix — a intensificat eforturile pentru a recupera teren. Samsung afirmă că a stabilizat randamentele pe cipurile DRAM de generația a cincea, cunoscute ca 1c, componentele fundamentale pentru SOCAMM2, ceea ce îi permite să scaleze producția într-un ritm comercial.

Ce este SOCAMM2 și ce oferă pentru infrastructura AI

SOCAMM2 combină densitatea memoriei LPDDR cu un design orientat spre server, reducând spațiul fizic ocupat și îmbunătățind eficiența termică. Pentru operatorii de centre de date și furnizorii de servicii cloud, avantajele includ costuri mai reduse pe terabyte, capacitate mai mare instalată per rack și flexibilitate în configurarea nodurilor de calcul. În practică, SOCAMM2 permite integrarea unui volum mare de memorie cu un cost total de proprietate (TCO) mai mic decât alternativele tradiționale în multe scenarii.

Trebuie menționat că SOCAMM2 nu înlocuiește în totalitate HBM (High Bandwidth Memory). HBM rămâne preferată pentru sarcini care necesită lățime de bandă extremă și latență foarte scăzută — de exemplu, anumite aplicații avansate de antrenare și inferență la scară largă. Totuși, SOCAMM2 oferă un echilibru între performanță și cost care îl face atractiv pentru multe configurații de server AI și pentru arhitecturi hibride CPU–GPU.

Progresul tehnic al Samsung: randamente și 1c DRAM

Stabilizarea randamentelor pe nodurile avansate este esențială pentru a transforma o tehnologie demonstrativă într-o ofertă de volum. Samsung raportează că îmbunătățirile în procesele sale de fabricație au redus rata defectelor pentru cipurile 24Gb LPDDR5X bazate pe arhitectura 1c, ceea ce înseamnă mai mulți cipuri utilizabili per wafer. Această eficiență crește capacitatea efectivă de producție și reduce costul unitar, un element-cheie atunci când se răspunde unor cereri uriașe cum ar fi cele ale Nvidia.

Pe lângă optimizarea randamentelor, Samsung a lucrat la proiectarea substraturilor SOCAMM2, la tehnici de împachetare și la controlul termic. Toate aceste elemente sunt necesare pentru a asigura compatibilitatea cu serverele de înaltă densitate și pentru a păstra fiabilitatea în condiții de încărcare continuă — un criteriu critic pentru centrele de date enterprise și cloud.

Impactul asupra platformelor Nvidia: Vera și Rubin

Nvidia a proiectat arhitecturi precum Vera ca gazdă pentru diverse module de memorie, iar integrarea SOCAMM2 oferă flexibilitate în proiectarea sistemelor. În configurațiile planificate, mai multe module SOCAMM2 sunt plasate în proximitatea procesorului Vera pentru a reduce latențele de acces și a alimenta GPU-urile Rubin cu fluxuri constante de date. Acest tip de integrare ajută la reducerea „memory bottlenecks” și la maximizarea utilizării acceleratorilor în sarcini AI intensive.

Dacă Samsung poate onora un volum mare din comenzile SOCAMM2, Nvidia va beneficia de o stabilitate mai mare în lanțul de aprovizionare, permițând planificarea lansărilor de hardware și actualizările de software la scară largă. Stabilitatea furnizării memoriei contribuie direct la predictibilitatea costurilor pentru clienți și la adoptarea mai rapidă a noilor platforme.

Scală și aprovizionare: cifrele

Conform rapoartelor din industrie, Nvidia a solicitat capacități de memorie SOCAMM la scară enormă — până la 20 de miliarde de gigabyți (GB) de module SOCAMM. În schema curentă de aprovizionare, Samsung ar urma să furnizeze aproximativ jumătate din acea capacitate, adică în jur de 10 miliarde GB. Pentru a atinge acest obiectiv, Samsung estimează că va avea nevoie de aproximativ 830 de milioane de cipuri DRAM de 24Gb LPDDR5X, ceea ce se traduce într-un necesar lunar de aproximativ 30.000–40.000 de plachete (wafere) — reprezentând aproximativ 5% din producția lunară totală de wafere DRAM a Samsung.

Aceste cifre pun în lumină provocările logistice și capabilitățile pe care le presupune producția la scară: stabilirea lanțurilor de aprovizionare pentru materiile prime, asigurarea capacității de testare și validare, managementul stocurilor și coordonarea cu assemblerii care montează modulele SOCAMM2 pe substraturi și le integrează în tray-uri pentru livrare.

Calculul capacității și implicațiile pentru producție

Cererea pentru 830 de milioane de cipuri de 24Gb este rezultatul unor calcule bazate pe densitatea modulului SOCAMM2 și pe capacitatea totală solicitată de Nvidia. În practică, volumul real necesar poate varia în funcție de configurațiile exacte ale modulelor, ratele de randament și pierderile din procesele de testare și împachetare. De aceea, planificarea include o marjă pentru rebuturi și pentru module reasamblate, precum și acorduri flexibile care permit ajustarea comenzilor în funcție de evoluția cererii și a randamentelor.

Pe termen scurt, dedicarea a circa 5% din producția lunară de wafere către un singur client reprezintă un angajament semnificativ, dar nu fără precedent; însă coordonarea între fabricile Samsung, furnizorii de echipamente și unitățile de testare este esențială pentru a menține termenele și calitatea.

Concurența: Micron și SK Hynix

Micron a condus lansarea SOCAMM în 2025 și rămâne un actor important, iar SK Hynix continuă să fie un competitor direct. În acest ecosistem, fiecare furnizor mizează pe mixul propriu de produse: Micron și SK Hynix pot acoperi porțiuni din cerere, iar Samsung oferă volum semnificativ în tandem cu potențiale comenzi HBM4. Această concurență contribuie la furnizarea unei oferte stabile pentru Nvidia, dar exercită presiuni asupra prețurilor și asupra marjelor producătorilor.

Distribuția comenzii între mai mulți furnizori ( Micron, SK Hynix, Samsung) reduce riscul de dependență, dar creează și nevoia pentru standarde comune de interoperabilitate, testare și certificare, astfel încât modulele SOCAMM2 produse de furnizori diferiți să funcționeze predictibil în aceleași platforme hardware.

Efectele asupra prețurilor și lanțurilor de aprovizionare

Dacă furnizorii pot crește eficiența producției și randamentele, oferta crescută ar putea tempera presiunea asupra prețurilor memoriei în 2026. Totuși, costurile de dezvoltare, investițiile în echipamente și cererea ridicată pentru materiale critice pot păstra un nivel de stabilitate a prețurilor mai sus decât în perioade de surplus. În plus, incidentele logistice, schimbările în politica de aprovizionare a anumitor componente sau fluctuațiile în cererea de servere AI pot influența dinamica prețurilor.

Pe scurt, dezvoltarea unui ecosistem SOCAMM2 la scară largă va remodela lanțurile de aprovizionare pentru memorie, va crea cerințe noi de testare și asamblare și va influența atât costurile de producție, cât și prețurile finale pentru operatorii de centre de date.

Previziuni și riscuri pentru 2026

În 2026, pe măsură ce furnizorii vor ramp up producția, este probabil să vedem o adopție mai largă a SOCAMM2 în serverele AI, îndeosebi în configurații unde echilibrul între cost și performanță contează. Totodată, rezultatul procesului de validare HBM4 al Samsung cu Nvidia va juca un rol esențial: un rezultat pozitiv ar putea genera cereri importante pentru HBM4, în special în segmentele de top unde lățimea de bandă maximă este critică.

Riscurile includ posibilitatea unor întârzieri în ramp-up din cauza problemelor de randament, constrângerilor la furnizarea materiilor prime sau schimbărilor bruște în planurile de achiziție ale clienților. De asemenea, dinamica concurențială (reduceri de preț, oferte agresive) poate afecta marjele furnizorilor. În aceste condiții, flexibilitatea în planificare și capacitatea de a ajusta volumele sunt factori cheie pentru succes.

În plus, factorii geopolitici și reglementările privind exporturile de tehnologii avansate pot influența disponibilitatea anumitor componente sau echipamente esențiale pentru producția DRAM și HBM, ceea ce trebuie monitorizat de furnizori și clienți deopotrivă.

Ce urmează: adoptare, validare și impact asupra industriei

Următoarele luni vor fi decisive pentru modul în care SOCAMM2 și HBM4 vor modela peisajul memoriei pentru AI. Așteptați-vă la o extindere treptată a adoptării SOCAMM2 pe măsură ce furnizorii ating volumele necesare și ca integratorii de sisteme să optimizeze designurile interne. Validarea HBM4 de către Nvidia și alți integratori va determina dacă HBM4 devine o opțiune de volum sau rămâne segment de nișă pentru anumite workload-uri.

Pe plan economic, contractele mari pentru SOCAMM2 și potențialele comenzi HBM4 pot conduce la creșteri semnificative ale veniturilor și profiturilor pentru furnizorii care livrează la timp și la calitate. Pentru operatorii de centre de date și pentru furnizorii de cloud, aceste evoluții pot însemna o gamă mai largă de opțiuni pentru optimizarea costurilor și a performanței aplicațiilor AI.

În concluzie, angajamentul Samsung de a furniza circa 50% din modulele SOCAMM2 solicitate de Nvidia marchează un punct de cotitură: pe măsură ce randamentele se stabilizează și capacitatea de producție crește, SOCAMM2 ar putea deveni un standard important în arhitecturile AI server, iar validarea HBM4 va completa portofoliul de opțiuni pentru memorie de înaltă performanță.

Sursa: sammobile

Lasă un Comentariu