10 Minute

Noua familie de TPU Ironwood de la Google a reaprins o dispută care mocnește în domeniul hardware-ului pentru inteligență artificială: de data aceasta adevăratul challenger pentru Nvidia nu mai este AMD sau Intel, ci siliciul personalizat al Google, optimizat pentru inferență. Cu o capacitate de memorie impresionantă, interconectări dense și revendicări agresive de eficiență energetică, Ironwood redefinește aspectul AI-ului în cloud la scară mare.

Ironwood prin cifre: memorie, calcul și un SuperPod care scalează

În esență, Ironwood (TPU v7) este conceput pentru un singur scop — servirea modelelor în producție. Google îl poziționează ca un cip „inference-first”, cu specificații construite pentru a reduce latența, a scădea energia consumată per interogare și a simplifica desfășurarea modelelor mari de limbaj (LLM) și a altor servicii AI în timp real. Această orientare spre inferență implică compromisuri deliberate în arhitectura cipului, prioritizând latența deterministă, latența tail și costul per query față de metrici pur de training.

- Putere de calcul maximă FP8 per cip: ~4.614 TFLOP

- Memorie on-package: 192 GB HBM3e (latime de bandă ~7–7.4 TB/s)

- Scalare pod: până la 9.216 cipuri per SuperPod

- Putere de calcul agregată per pod: ≈42,5 exaFLOPS (FP8)

- HBM sistem per pod: ~1,77 PB

Aceste cifre brute contează, dar povestea este la fel de mult despre modul în care cipurile comunică între ele. Google utilizează un InterChip Interconnect (ICI) și un layout în formă de tor 3D pentru a conecta numeroase cipuri într-un SuperPod coerent, bazându-se pe o rețea de tip scale-up și pe o legătură inter-pod de 1.8 PB care menține modelele mari rezidente în memorie rapidă, în loc să mute greutățile prin legături mai lente. Strategia aceasta reduce traficul de date pe link-uri externe și minimizează paginarea sau transferurile către memorie mai lentă, care pot introduce latențe inconsistente.

Pe lângă capacitatea brută de memorie și bandă, proiectarea fizică a plăcilor, profilarea termică și optimizările pentru managementul alimentării (power delivery) contribuie la stabilitatea operațională a unui SuperPod. Mai multe niveluri de memorie on-package înseamnă că un model de dimensiuni mari poate rămâne complet în HBM-ul rapid al sistemului, evitând I/O-ul repetat către stocare sau DRAM mai lentă. Acest lucru este esențial pentru servicii cu cerințe stricte de latență, cum ar fi chatbots în timp real, asistență vocală sau inferență multimodală.

De ce inferența schimbă harta competitivă

Anterior, antrenamentul era teatrul principal al competiției: TFLOPS brute, bazine masive de memorie și kernel-uri optimizate erau metricile-cheie, iar GPU-urile Nvidia dominau acest spațiu. Economia AI se schimbă însă. După ce modelele sunt antrenate, sarcina reală devine compusă din miliarde de interogări de inferență — nu din execuții de training. Aceasta pune accent pe latență, throughput per query, energie per query și eficiența costurilor de operare.

.avif)

Ironwood a fost proiectat cu aceste metrici în centrul atenției. Memoria on-package mare reduce comunicarea între cipuri pentru modelele voluminoase, scăzând astfel latența. Google afirmă că Ironwood oferă îmbunătățiri semnificative de performanță generațională și de eficiență energetică (compania revendică aproximativ 2× câștig de eficiență energetică față de generațiile anterioare de TPU). Pentru hyperscalers și clienții cloud care plătesc pentru capacitate de inferență 24/7, această eficiență se poate traduce în economii de costuri substanțiale.

Pe plan tehnic, inferența introduce cerințe diferite față de training: predictibilitatea latenței la percentila 99.9, stabilitatea prin variații de load și costul marginal pe fiecare request devin decizionale. Optimizările pentru inferență includ compresia modelului (quantization), utilizarea formatelor de cele mai multe ori FP8 sau int8, caching de activări și partiționarea modelului astfel încât cele mai accesate părți rămân în memoria cea mai rapidă. TPU-urile Ironwood par să abordeze toate aceste aspecte prin hardware + interconectare și prin integrarea cu stack-ul software Google Cloud.

De asemenea, pentru aplicații precum LLM-urile conversaționale, latența tail (vârfurile de latență) poate afecta experiența utilizatorului mai mult decât latența medie. Reducerea variabilității prin menținerea modelului în HBM3e și printr-o rețea de interconectare internă robustă este un avantaj competitiv concret în scenarii de producție la scară mare.

Interconecturi, SuperPod-uri și blocarea ecosistemului (ecosystem lock-in)

Un alt avantaj competitiv al Google este integrarea verticală. Oferind Ironwood prin Google Cloud, compania poate optimiza întregul stack — hardware, rețelistică și runtime — pentru a reduce costul per interogare. Abordarea SuperPod, cu interconect dens și o arhitectură scale-up, este proiectată pentru a deservi modele foarte mari cu penalități de performanță mai reduse decât ar întâmpina un cluster GPU fragmentat, construit din noduri distribuite și legături externe.

Această integrare verticală creează, totodată, riscuri strategice pentru competitori precum Nvidia. Chiar și cu rack-urile Rubín și cu GPU-urile Blackwell B200 orientate spre inferență, clienții cloud ar putea prefera infrastructura nativă TPU dacă reduce în mod demonstrabil latența și costurile operaționale. Rezultatul ar putea fi o blocare mai puternică (vendor lock-in) la arhitectura hardware a furnizorului de cloud ales.

Lock-in-ul apare din combinarea performanței hardware cu optimizările software care fac dificilă migrarea: modele adaptate la anumite biblioteci, toolchain-uri de conversie, optimizări specifice de compilation și instrumente de monitorizare și observabilitate legate de infrastructură. De exemplu, un LLM optimizat pentru latența și profilele de memorie ale unui SuperPod Ironwood poate necesita retuning sau recompilare semnificativă pentru a rula eficient pe o platformă GPU tradițională.

Totuși, integrarea strânsă nu este doar o armă strategică; este și un avantaj operațional pentru clienți: management centralizat, contracte de servicii, SLA-uri clare și acces la instrumente de orchestration care pot facilita implementarea modelelor la scară. Pentru companii care valorează predictibilitatea costurilor și performanța deterministă, acest pachet integrat poate fi preferabil față de o arhitectură multi-cloud sau hibridă mai fragmentată.

Jensen Huang a observat

CEO-ul Nvidia, Jensen Huang, a recunoscut public cât de dificil este să construiești ASIC-uri personalizate și a semnalat TPU-urile ca un competitor real. Această recunoaștere contează: atunci când un incumbent dominant numește o tehnologie rivală ca amenințare, de obicei urmează investiții concentrate și cicluri de produs mai rapide din ambele tabere. Aprecierea publică din partea liderilor de piață tinde să accelereze ritmul inovației și să mobilizeze resurse—atât în cercetare, cât și în optimizare software.

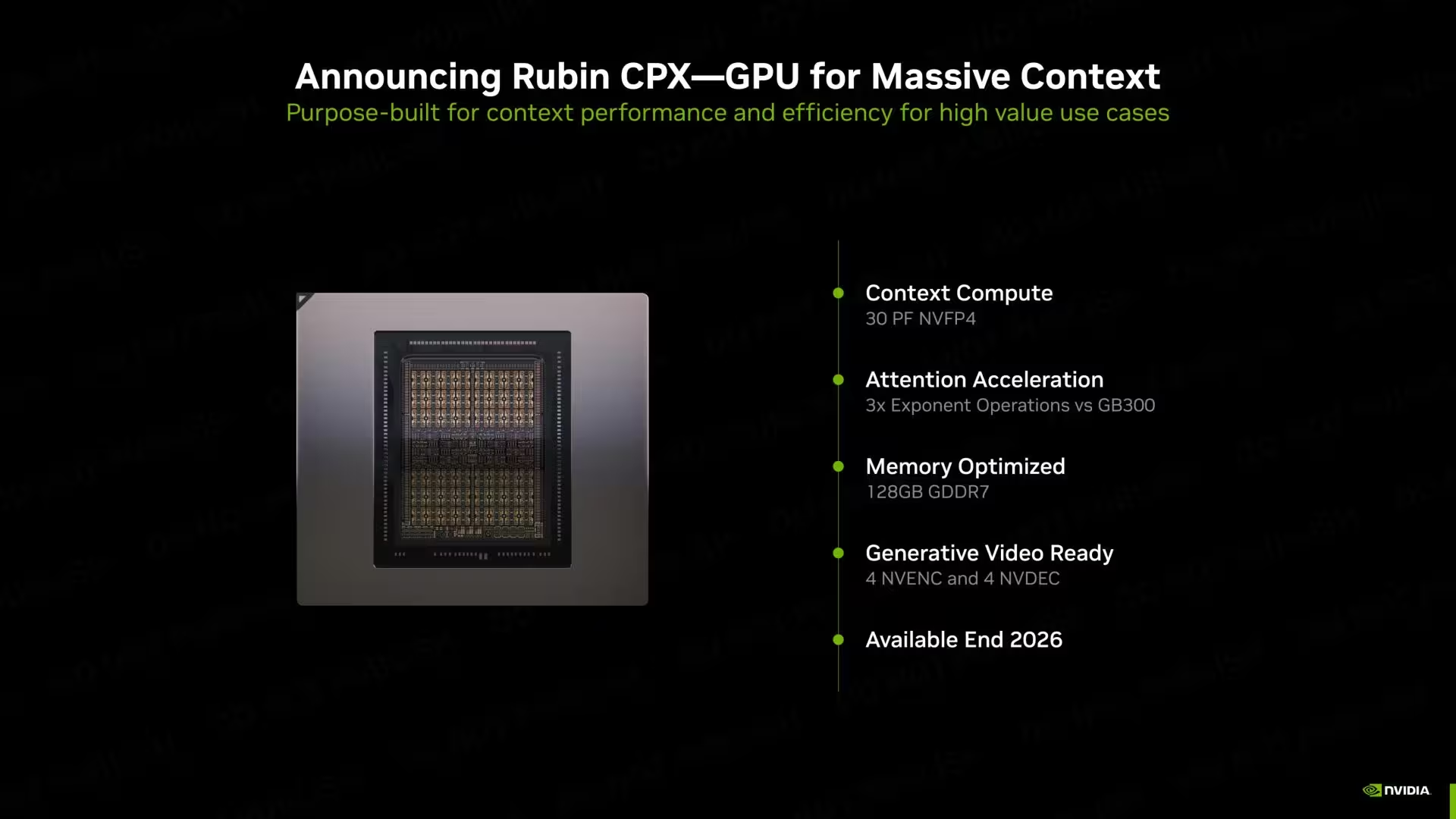

Reacția Nvidia nu a întârziat: compania investește în optimizări hardware orientate spre inferență, dezvoltă soluții pentru rack-uri integrate și extinde ecosistemul software pentru a îmbunătăți cost-per-query și latența în scenarii critice. Totodată, parteneriatele cu furnizorii de cloud și ofertele hibrid-cloud sunt strategii menite să păstreze clienții acolo unde performanța-per-dollar rămâne competitivă.

Așadar, Nvidia este condamnată?

Deloc — dar regulile se schimbă. Nvidia rămâne în frunte la calcul GPU versatil, un ecosistem software masiv (CUDA, cu întreg stack-ul de optimizări) și o adoptare largă pe piață pentru training și multe scenarii de inferență. Ce deschide Ironwood este însă un nou ax de competiție centrat pe economia inferenței. Pentru companiile care rulează implementări masive, în timp real, strategia TPU a Google ar putea deveni factorul decisiv.

În practică, decizia asupra platformei va depinde de mai multe elemente: tipul de model (transformer, mixture-of-experts, modele multimodale), modelele de acces (latency-sensitive vs batch), costurile marginale, cerințele de securitate și conformitate, precum și preferințele operaționale ale echipei DevOps. Unele organizații vor rămâne la GPU pentru flexibilitate la training și inferență mixtă; altele vor migra pentru eficiența costurilor și latența redusă oferite de un cloud natif TPUs ca Ironwood.

Pe termen mediu, așteptați-vă la o diversificare a ofertelor: furnizorii cloud vor continua să ofere opțiuni GPU și TPU, iar instrumentele de portare și compilare (de exemplu XLA, compilers proprietari și formate intermediare) vor evolua ca să faciliteze migrarea modelelor între arhitecturi. În plus, standardele emergente pentru modele și formatele de stocare a parametrilor pot reduce treptat costurile de lock-in tehnologic.

Pe scurt: concursul din AI evoluează de la „cine are cei mai mulți FLOPS” la „cine servește cele mai multe interogări, cel mai ieftin și cel mai rapid”. Cu Ironwood intrând în producție, anticipați că furnizorii cloud, hyperscalers și companiile vor reevalua unde să ruleze sarcinile de inferență — iar asta îl face pe Google provocatorul cel mai interesant de urmărit în acest moment.

Mai mult, pe măsură ce cererea pentru aplicații AI în timp real crește — de la asistenți conversaționali la sisteme de recomandare și analiză în timp real — optimizările end-to-end oferite de Ironwood (hardware + rețea + stack software) pot transforma costurile operaționale și nivelul serviciilor. Adoptarea pe scară largă va depinde însă de transparența performanțelor în condiții reale de producție, de instrumentele de migrare și de costurile comparate pe termene medii și lungi.

În concluzie, nu este vorba doar despre un singur produs: Ironwood pune sub lupă modul în care proiectăm infrastructura pentru AI la scară, ce compromisuri suntem dispuși să facem între flexibilitate și eficiență și cum se vor repoziționa jucătorii mari într-o lume în care inferența devine centrul valorii comerciale a inteligenței artificiale.

Sursa: wccftech

Lasă un Comentariu