11 Minute

OpenAI a lansat GPT-5-Codex-Mini, o variantă compactă și accesibilă din punct de vedere financiar a modelului Codex bazat pe GPT-5, concepută pentru a oferi dezvoltatorilor acces mai ieftin la generare avansată de cod și asistență în ingineria software. Modelul urmărește să aducă capabilități utile pentru scrierea de cod, testare automată și refactorizare, menținând în același timp un nivel de eficiență care să permită echipelor să ruleze mult mai multe sarcini fără a suporta costuri proporțional mai mari. Prin poziționarea sa ca un model 'mini', OpenAI urmărește să extindă adoptarea instrumentelor de automatizare a codului în echipe mici, startup-uri sau cicluri de dezvoltare cu volum mare, fără a compromite funcționalitățile esențiale care definesc seria Codex.

What the new mini model offers

GPT-5-Codex-Mini este versiunea mai mică, optimizată din punct de vedere al costurilor, a GPT-5-Codex. Scopul său este să livreze majoritatea capabilităților de bază pentru programare — precum generarea de proiecte noi, adăugarea de funcționalități și teste unitare, refactorizări la scară largă și asistență pentru debugging — în timp ce reduce cheltuielile de calcul (compute) astfel încât echipele să poată rula mult mai multe sarcini cu același buget. În practică, OpenAI susține că Mini permite aproximativ de patru ori mai multă utilizare comparativ cu versiunea completă GPT-5-Codex, renunțând doar la un declin modest în acuratețe și raționament. Această compromis este conceput pentru a satisface cazuri de utilizare în care volumul și costul sunt factorii critici, de exemplu: generare de cod la scară, completări automate în editor, și rulare de teste automate în pipeline-urile CI/CD. Din perspectiva ingineriei software, modelul păstrează suportul pentru limbaje populare (de la Python și JavaScript până la Java, C# și limbaje de script), precum și capabilități de înțelegere a contextului proiectului, navigare prin fișiere și sugerare de modificări coerente. Optimizările care intră în categoria "cost-reduced" includ decizii de arhitectură pentru parametri, quantizare selectivă sau politici de inferență adaptivă care reduc timpii de GPU și consumul de memorie, menținând însă un comportament suficient de robust pentru majoritatea sarcinilor de rutină. În plus, Codex-Mini păstrează integrarea cu instrumentele de dezvoltare existente: pluginuri IDE, interfață CLI și extensii pentru pipeline-uri de integrare continuă, facilitând adoptarea fără necesitatea de reconfigurări ample.

How it performs: real benchmark numbers

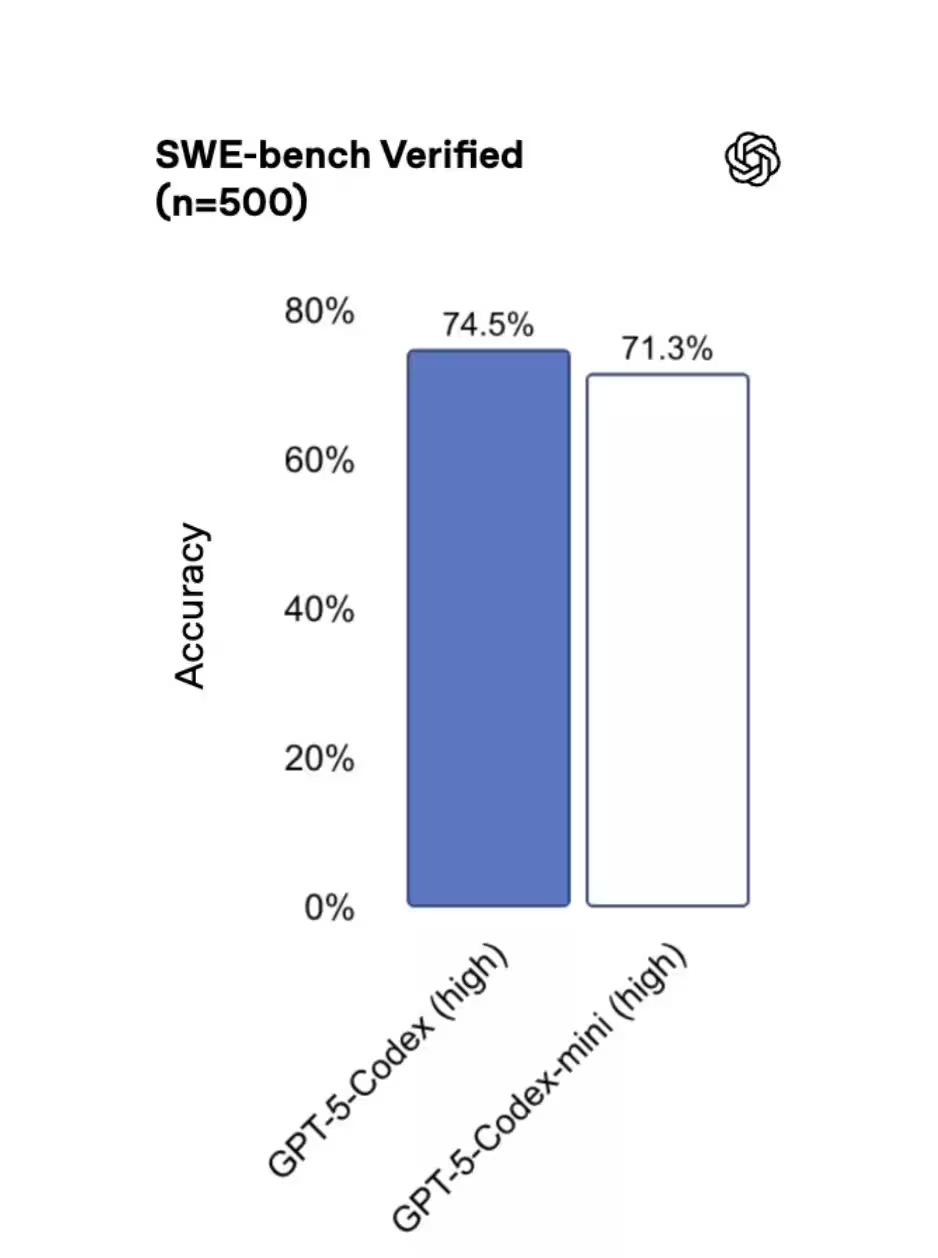

Benchmark-urile publice oferă o privire comparativă utilă: pe SWE-bench Verified, cele trei modele s-au situat destul de apropiat: GPT-5 High a obținut 72.8%, GPT-5-Codex 74.5%, iar GPT-5-Codex-Mini a înregistrat 71.3%. Aceste rezultate indică faptul că Mini reține o parte importantă din punctele forte ale modelului original, în special pentru sarcinile tipice de generare și modificare de cod. Diferențele în procente trebuie interpretate contextual: o scădere de câteva procente în benchmark nu echivalează întotdeauna cu o pierdere perceptibilă în scenarii practice, în special atunci când costul permite rulări suplimentare, verificări automate și pipeline-uri de testare care compensează eventualele erori. Analiza mai detaliată a rezultatului sugerează câteva puncte cheie: (1) Mini tinde să funcționeze excelent pe sarcini bine definite, cu specificații clare și teste asociate; (2) sarcinile care necesită raționament multi-pas sau înțelegere profundă a arhitecturii unui proiect foarte mare pot observa degradări ușoare; (3) pentru operațiuni de refactorizare la scară, utilizarea combinată (de exemplu, propunere inițială de la Mini, verificare și corecție cu modelul complet) poate oferi un echilibru optim între cost și calitate. În practică, multe echipe vor rula A/B testing intern pentru a determina pragurile la care diferențele de performanță devin semnificative pentru fluxurile lor de lucru specifice. Pe lângă scorurile brute, contează și metrici operaționale: latență, stabilitate la incarcări ridicate, și consistența răspunsurilor la prompturi similare. OpenAI a publicat date despre îmbunătățiri în infrastructură care reflectă o mai bună predictibilitate în aceste dimensiuni, fapt ce face din Mini o opțiune practică pentru scenarii cu volum mare de solicitări unde costurile GPU sunt o constrângere.

When developers should pick the Mini

Când este potrivit să alegi Mini? OpenAI recomandă utilizarea GPT-5-Codex-Mini pentru sarcini de inginerie mai ușoare sau ca fallback atunci când atingi limitele de utilizare ale modelului principal. Tooling-ul Codex chiar sugerează comutarea la Mini când consumul ajunge în jurul a 90% din cota alocată. Gândește-te la Mini ca la un throttling economic: păstrează joburile critice și cu risc ridicat pe modelul complet și mută munca de volum mare sau de risc scăzut pe Mini pentru a extinde bugetul și throughput-ul. Exemple concrete de scenarii în care Mini este o alegere inspirată: generare de boilerplate, completări de cod repetitive, generare de teste unitare inițiale, revizuiri automate de stil de cod și sugestii de optimizare care pot fi ulterior validate de build-uri automate. Totodată, pentru task-urile care implică manipulări masive de fișiere sau analize pe proiecte mari (de exemplu, refactorizări transversale care ating sute de fișiere), strategia recomandată ar fi hibridă: folosește Mini pentru propunerile inițiale și rulează validarea finală sau corecțiile sensibile cu modelul GPT-5-Codex complet. Pentru echipele care folosesc modele în pipeline-uri CI/CD, recomandările practice includ: (1) definirea unor politici de fallback automat care trimit joburile non-critice către Mini când cotele sunt aproape de limită; (2) introducerea de etape de validare care să compare rezultatul Mini cu cele istorice pentru a detecta regresii; (3) monitorizarea continuă a ratei de succes a testelor generate automat și ajustarea pragurilor; (4) folosirea de toggles (feature flags) pentru a activa/dezactiva fluxuri care rulează pe Mini în perioade de trafic intens; (5) planificarea unui buffer de cost pentru a permite comutarea spre modelul complet în timpul lansărilor critice. Adoptarea Mini este deosebit de avantajoasă pentru organizațiile care prioritizează scalabilitatea cost-eficientă: startup-uri cu echipe tech reduse, echipe de DevOps care rulează numeroase pipeline-uri nightly, sau companii care vor să automatizeze sarcini repetitive de cod fără a sacrifica observabilitatea și calitatea finală.

Where you can use it today

Mini este deja disponibil în Command Line Interface (CLI) și ca plugin pentru IDE, iar suportul API este programat să apară în curând. Aceasta înseamnă că dezvoltatorii pot integra modelul în fluxuri locale de lucru, pipeline-uri CI, și sesiuni de codare asistată din editor imediat — înainte de finalizarea unui rollout API mai larg. Disponibilitatea în CLI facilitează rulări batch, automatizări și integrarea cu scripturi de build; pluginul pentru IDE oferă completări în timp real, sugestii de refactor și generare de teste direct în contextul fișierelor deschise. Integrarea imediată în mediile existente este un plus pentru adoptarea practică: echipele pot insera apeluri către Mini în sarcini cron, job-uri de linting automat, sau ca parte a evaluărilor de pull request. De exemplu, un workflow comun ar putea fi: la deschiderea unui pull request, rulați un job care cere Mini să genereze test cases sugerate pentru noile funcționalități; dacă acele teste trec în pipeline, ele pot fi promote; dacă nu, se poate escalada verificarea la modelul complet. Această abordare combină viteză, acoperire și un cost controlat. Pe măsură ce API-ul devine disponibil mai larg, implementările tipice vor include: apeluri REST/SDK pentru generare de cod la cerere, integrare cu webhooks pentru evaluări automate, și conectarea la sisteme de observabilitate (monitorizare, logare, alertare) pentru a urmări performanța și rata de succes a recomandărilor oferite de model. De asemenea, echipele de testare și securitate vor dori să includă reguli specifice de scanning pentru a verifica dacă sugestiile generate respectă politicile interne și cerințele de securitate (de exemplu, evitarea inclusiunii de chei secrete sau de cod vulnerabil).

Behind the scenes: performance and reliability upgrades

OpenAI a anunțat, de asemenea, îmbunătățiri de infrastructură menite să facă utilizarea Codex mai predictibilă. Lucrările de eficiență GPU și optimizările de rutare au permis creșterea limitelor de rată (rate limits) cu 50% pentru abonații ChatGPT Plus, Business și Education. Clienții Pro și Enterprise beneficiază de procesare prioritară pentru a păstra viteza și capacitatea de răspuns la vârf. Problemele anterioare cauzate de erori de caching, care redusese capacitatea utilă, au fost remediate, astfel încât dezvoltatorii ar trebui să observe o experiență mai stabilă și mai fiabilă pe tot parcursul zilei. Din punct de vedere tehnic, optimizările includ planificarea mai eficientă a joburilor pe clustere GPU, mecanisme de autoscaling pentru a răspunde la spike-urile de trafic și politici îmbunătățite de retry și circuit-breaking pentru a evita degradarea în caz de incidente. Aceste schimbări cresc predictibilitatea latențelor și reduc variațiile în performanță care pot afecta integrările sensibile la timpii de răspuns. În plus, prioritizarea clienților Pro/Enterprise asigură că sarcinile critice rămân fluide chiar în perioadele de încărcare maximă. Pentru echipele care rulează aplicații de producție, recomandările practice pe partea de fiabilitate includ: implementarea de fallback la Mini când serviciile principale sunt degradate, folosirea de timeouts și retry-uri exponentiale, logarea detaliată a prompturilor și a răspunsurilor pentru audit și analiză post-mortem, și instrumentarea pentru a urmări costul per solicitare (cost per call) în paralel cu metrici de calitate (ex. rata de succes a testelor generate). De asemenea, se recomandă pilotarea inițială pe subseturi de proiecte reprezentative pentru a înțelege comportamentul modelului în contexte reale înainte de un rollout complet.

Bottom line: GPT-5-Codex-Mini oferă echipelor o cale practică de a scala automatizarea programării fără o creștere proporțională a costurilor. Pentru mulți dezvoltatori va fi alegerea mai inteligentă pentru sarcini de volum mare sau cu risc scăzut — în special în timp ce OpenAI continuă să extindă accesul API și să întărească garanțiile de performanță. În final, decizia de a folosi Mini ar trebui să fie parte a unei strategii mai largi de orchestrare a modelelor: evaluare cost-beneficiu, monitorizare continuă, fallback-uri și proceduri de escaladare pentru sarcinile critice. Astfel, organizațiile pot beneficia de automatizarea codului la scară, reducând timpul de dezvoltare și îmbunătățind productivitatea echipelor, păstrând totodată un control strict asupra costurilor și calității livrabilelor.

Sursa: smarti

Lasă un Comentariu